CCP:DE Data Engineer數據工程師認證考試

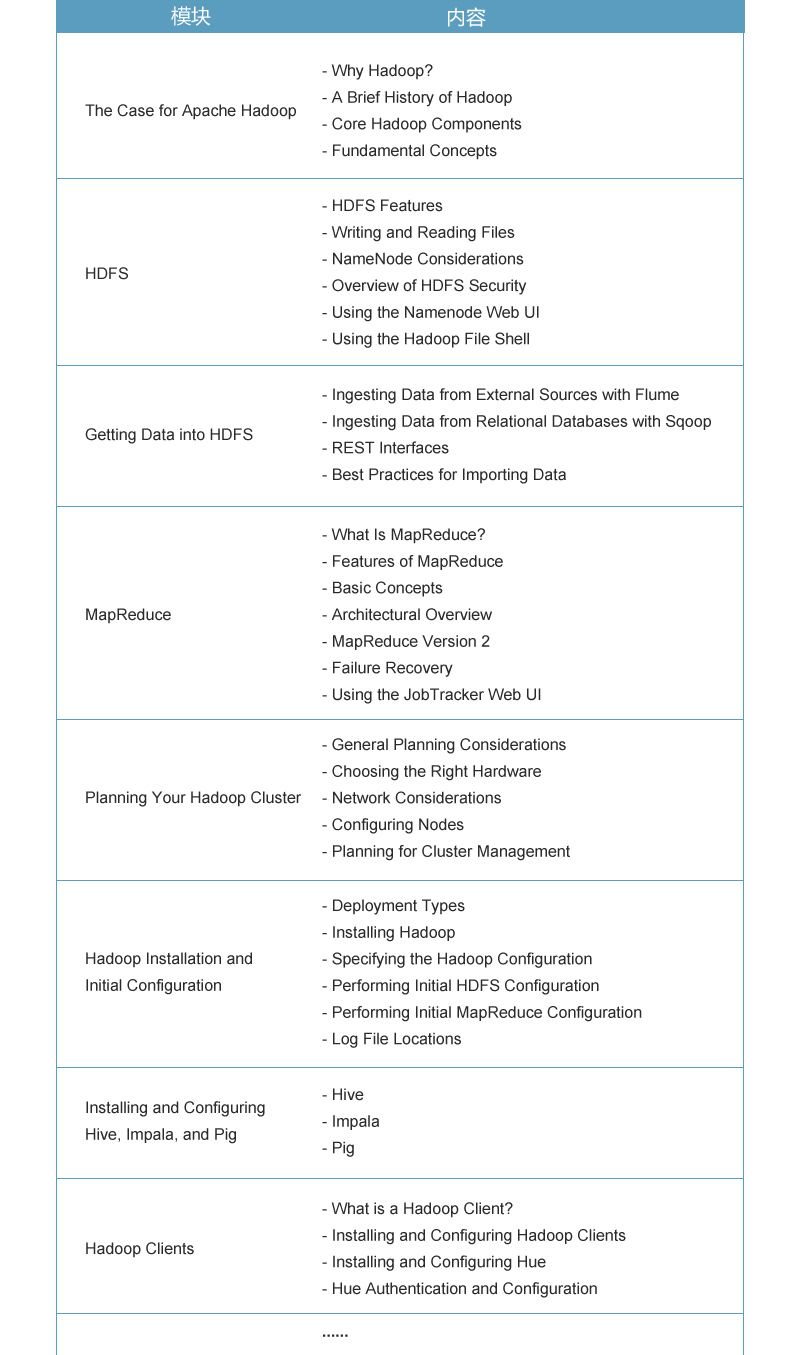

課程大綱

認證須知

開課計劃

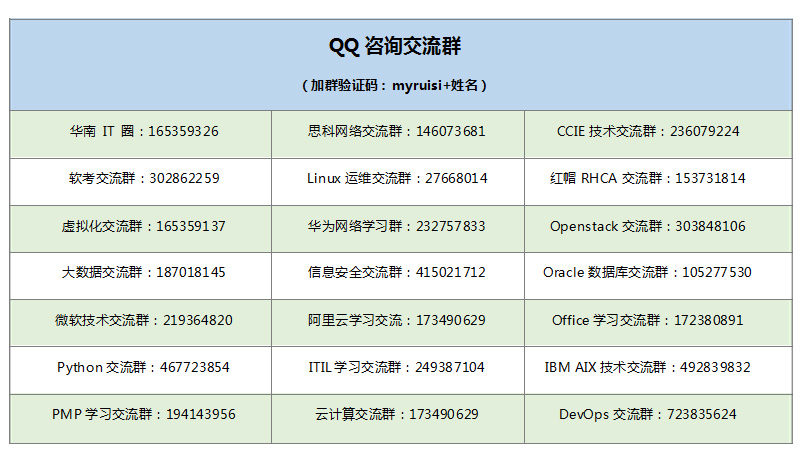

學習QQ群

常見問題

認證準備建議:Spark and Hadoop開發者培訓;設計及構建大數據應用;考生需對Hadoop有深入了解、具有實際使用大數據工具的經驗、以及具備解決實際數據工程問題的專家級水平

考試形式:4小時;提供一個大數據集供使用、7個高性能節點組成的CDH5機群;解決大數據用戶可能碰到的5-8個實際問題

考試大綱

數據攝取

內部系統與集群之間進行數據傳輸所需技能如下:

外部RDBMS和集群之間導入和導出,包括能夠導入特定的子集,數據攝取過程中改變所輸入文件的分隔符和文件格式,改變數據輸入形式或權限。

將實時及近乎實時的流數據攝入HDFS,包括能夠分配給多數據源,轉化數據格式。

使用Hadoop 文件系統代碼加載數據到HDFS及從HDFS加載數據。

轉化、展現、存儲

將存儲在HDFS上的一組特定格式的數據值轉化成新數據值或新數據格式,并寫入HDFS或Hive/HCatalog。需要如下技能:

將數據從一種格式轉化成另一種格式

用壓縮形式寫數據

將數據從一組值轉化成另一組值(如:使用一個外部庫將經緯度轉化成郵政地址)

轉換數據集值的數據格式

清理數據集中不良記錄,如:空值

去除重復數據、整合數據

反范多個不同數據集的數據

進化Avro或Parquet格式

根據一個或多個分區鍵對現有數據集進行分區

調整數據實現最優查詢

數據分析

過濾,分類,連接,匯總以及轉化存儲在HDFS上的一個或多個有既定數據格式的數據集,產生一個特定的結果。所有這些任務可能包括從Parquet, Avro, JSON, delimited text, and natural language text中讀取文件。這些查詢包括復雜的數據形式(如:array, map, struct),還包括外庫的執行、分區數據、壓縮數據。同時這些查詢也需要從Hive/HCatalog中使用元數據。

寫查詢,匯總多數據行

寫查詢,計算匯總統計

寫查詢,過濾數據

寫查詢,產生分級數據

從HDFS現有的數據中讀取或創建一個Hive或HCatalog表

工作流

創建、執行多個任務和操作,使數據向更大的價值方向轉化,并在一個系統使用,所需的技能包括:

創建、執行一個線性的操作工作流,其中包括Hadoop 作業、Hive 作業、Pig作業、自定義操作等

創建、執行一個分支操作工作流,其中包括Hadoop 作業、Hive作業、Pig作業、自定義操作等

編排一個工作流定期執行,其中包括有數據依賴性的工作流

考試形式

將給到你5到8個客戶問題,每個問題都是獨立的、大數據集、一個CDH集群,答題時間是4小時。對于每個問題,你必須提供一個高精度的技術解決方案,這個方案必須符合所有要求。 你可以使用任一工具或在集群上結合多個工具使用(參見下面列表)。你選擇的工具必須是符合這個作業的。另外,你必須擁有豐富的行業知識來分析問題,在給定時間內找到最佳方案。你需要了解你應該做什么,在嚴格的條件下在真實集群上進行操作。答題期間有時間限制,也有監考官監考。

關于備考

CCP數據工程師考生應該具備深厚的數據工程開發經驗、熟練掌握以上提及的技能。此考試旨在發掘有能力的數據專業人員,讓他們脫穎而出,技能被雇主認可。除了實操經驗,推薦專業人士參加Cloudera 的Spark and Hadoop開發者培訓課程來輔助獲得認證。

預約試聽

- *您的稱呼:

- *您的郵箱:

- *您的QQ號:

- 您的手機號:

- 公司名稱:

- 留言:

- 您的職務:

77869288

77869288